欢迎来到澜舟孟子社区!

澜舟科技为有兴趣入门 NLP 技术的开发者提供各种学习资源指引

扫码加入孟子开源社区微信群

扫码加入孟子开源社区微信群NLP 入门基础课程

NLP 高级课程

澜舟科技孟子模型技术解读

10月24日,澜舟科技开源发布了轻量级中文预训练语言模型——孟子模型,共包含4个模型:BERT-style的语言理解模型、T5-style文本生成模型、金融分析模型和多模态预训练模型,分别适用于多种常见的应用场景。相比于市面上已有的中文预训练模型,孟子模型具有轻量化和易部署的特点,性能上超越同等规模甚至更大规模的模型。此外,孟子模型采用通用接口、功能齐全、覆盖任务广,不仅可用于常规的语言理解和生成任务,亦可应用于金融垂直领域和多模态场景中。本文将对孟子模型的研究架构和技术原理进行解读,力图让用户更好地了解和使用孟子模型,并期待共同参与到孟子模型的建设之中。

孟子模型#

近年来,以ELMO和BERT为代表的大规模预训练技术快速推动了自然语言处理的发展,成为了自然语言处理的新范式。一系列预训练策略、模型结构改进、训练效率优化技术被提出,从而提升模型训练效率和性能。然而模型参数量与训练所需的数据量的爆炸性增长导致训练价格显著增长。在实际任务应用中,巨型模型面临与下游任务不能灵活适配、实施代价大等问题。此外,已有的研究通常关注英文,而中文相关的研究甚少。面向对文本理解,文本生成,以及垂直领域和多模态场景下的应用需求,如何在有限的时间和资源条件下,构建性能强劲的中文模型是一项重要挑战。

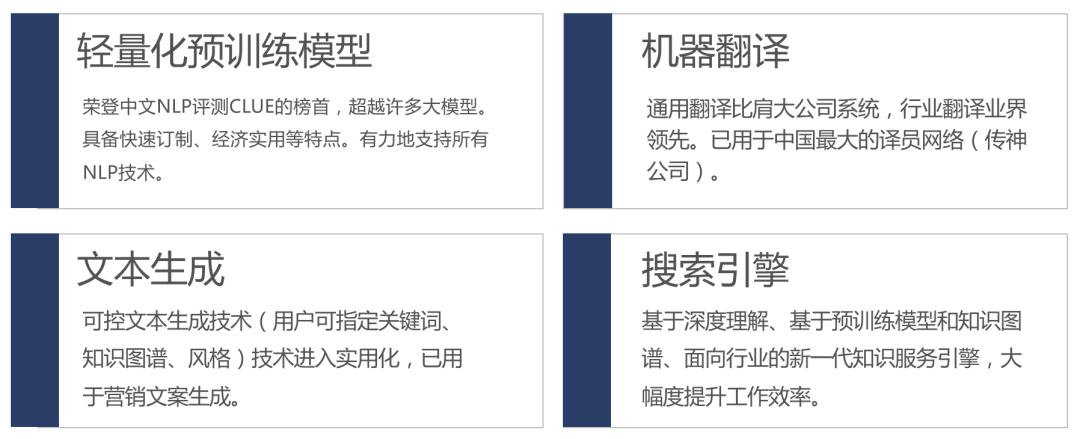

为更好地推动中文信息处理,促进自然语言处理技术在更广泛实际场景中的应用,澜舟科技致力于研发轻量化预训练模型,以及建立在其上的先进的机器翻译、文本生成和行业搜索引擎,覆盖文本理解(BERT-Style)、文本生成(T5-Style)、金融分析、多模态分析等常用领域,并通过开源、SaaS和订制等方式赋能行业客户,有利于快速、低成本地落地现实业务场景。

接下来,我们将分别解读四个模型所应用的核心技术。

孟子语言理解模型(Mengzi-BERT-base)#

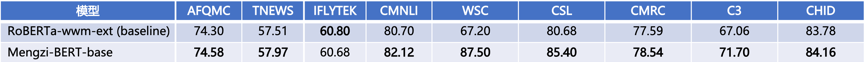

孟子语言模型作为语言编码的核心组件,不仅可独立应用于语言理解,也是其他三个模型的基石—作为核心的语言编码模块。为确保通用性并方便应用于下游系统,孟子模型与BERT 保持一致的模型结构,侧重于预训练目标和训练策略上的改进,研究更精巧、更有效、更鲁棒的预训练模型[1]。相较于其他中文预训练模型,孟子模型使用针对中文优化的切分器,可包含更多的中文词汇,处理更长的文本,更少地使用显存,并具有更快的推理速度。数据上,精选高质量、书面风格的语料用于训练,可用于文本分类、实体识别、关系抽取、阅读理解等任务。在CLUE评测上,孟子语言理解模型相比开源的RoBERTa模型体现出了明显的优势。

- 孟子语言理解模型总体研究框架不仅集成了被广泛证明有效的目标策略,也包含创新的预训练技术。以下主要介绍其中3项代表性策略:显性知识增强:语言建模的核心是从大规模数据中自动捕获知识。知识分为显性知识和隐性知识[2]。显性知识是能用文字和数字表达出来的,容易以硬数据的形式交流和共享,并且经编辑整理的程序或者普遍原则。隐性知识是高度个性而且难于格式化的知识,包括主观的理解、直觉和预感。传统NLP研究常常采用语言标注信息作为显性知识来增强语言表示[3],进而更好地在模型隐层中挖掘隐性知识,如向词嵌入表示(Word Embedding)中融合词性标注(POS)和命名实体(NER)。在预训练模型时代,已有研究表明预训练模型依然处于欠拟合状态[4][5],有效地引入人类先验知识或常识有助于提升模型的语言理解和推理能力[6][7][8]。启发于多任务语言学增强研究[9],将POS和NER的标注任务,作为语言建模的辅助任务,从而进行联合训练。具体而言,我们使用SpaCy对输入的文本进行词性标注和命名实体识别,将识别的目标标签作为预测目标用于训练。最后将原始的基于掩码建模(MLM)的损失与POS、NER的预测损失相加求和作为最终损失。

- 序列关系目标:文本理解任务通常涉及句子或篇章间关系,已有许多研究探讨了下一句预测(NSP)、句子顺序预测(SOP)[10]等句间关系建模方法。我们发现,结合SOP的训练任务有助于进一步提升模型性能。

- 训练偏差纠正:我们研究发现被广泛使用的MLM策略由于会在原文中按特定比例用特殊符号([MASK])替换原始词语,会一定程度上造成对原始句子结构破坏,并增大预测难度,却不符合真实的句子形式,因此可能造成对原始句子语义建模偏差。为应对此类问题,我们提出一系列策略对训练梯度进行纠正,更准确地还原真实、合法的句子结构,同时提升模型鲁棒性。

孟子金融模型(Mengzi-BERT-base-fin)#

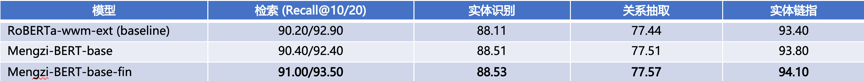

当前各类中文开源模型多面向通用领域,在包含金融在内的垂直领域缺乏相应的开源模型。为应对相应的需求,我们基于孟子语言模型模型和参数,在金融语料上继续训练,语料覆盖金融新闻,公告和研报等,可用于金融新闻分类、研报情感分析等任务。在金融领域任务上,相比于开源的RoBERTa基准模型,孟子金融模型取得了明显的性能提升。

孟子文本生成模型(Mengzi-T5-base)#

基于T5采用的Encoder-Decoder架构,在以孟子语言理解模型作为编码器以外,增加同等规模的解码器结构,训练方式上沿用T5的去噪策略,具备良好的训练效率。相比于BERT和GPT模型,孟子文本生成模型能更好地服务于可控文本生成需求,可应用于文案生成、新闻生成和研报生成等。

孟子多模态模型(Mengzi-Oscar-base)#

由于适用于中文的开源多模态模型稀缺,为应对多模态领域的现实应用需求,我们研发了孟子多模态模型。孟子多模态模型采用Oscar多模态架构,基于图文对齐数据训练,语言编码模块使用孟子语言理解模型和参数,可应用于图片描述、图文互检等任务。

孟子开源社区#

澜舟科技拥抱开源文本,期待跟社区一起成长。首次发布的模型发布均为base的alpha版本,对于不完善的地方欢迎反馈!除本文提到的技术细节以外,还有许多正在深入研究的前沿技术。经严谨评测稳定版本后,我们将会进一步开源发布最新成果。

孟子模型发布后,我们收到了许多反馈。为更好地回馈社区,我们在GitHub整理了常见问题的FAQ,并将不断更新,欢迎保持持续关注和反馈建议!

参考文献:

[1] Zhuosheng Zhang, Hanqing Zhang, Keming Chen, Yuhang Guo, Jingyun Hua, Yulong Wang, Ming Zhou. 2021. Mengzi: Towards Lightweight yet Ingenious Pre-trained Models for Chinese.

[2] Michael Polanyi. 1958. Personal Knowledge: Towards a Post-Critical Philosophy.

[3] Xiaodong Liu, Yelong Shen, Kevin Duh, Jianfeng Gao. 2018. Stochastic Answer Networks for Machine Reading Comprehension. In Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), pages 1694–1704.

[4] Yinhan Liu, Myle Ott, Naman Goyal, Jingfei Du, Mandar Joshi, Danqi Chen, Omer Levy, MikeLewis, Luke Zettlemoyer, and Veselin Stoyanov. 2019. RoBERTa: A robustly optimized BERT pre-training approach. arXiv preprint arXiv:1907.11692.

[5] Anna Rogers, Olga Kovaleva, and Anna Rumshisky. 2020. A primer in bertology: What we know about how BERT works. Transactions of the Association for Computational Linguistics, 8:842–866.

[6] Zhuosheng Zhang, Yuwei Wu, Hai Zhao, Zuchao Li, Shuailiang Zhang, Xi Zhou, and Xiang Zhou. 2020. Semantics-aware BERT for language understanding. In The Thirty-Fourth AAAI Conference on Artificial Intelligence, AAAI 2020, pages 9628–9635.

[7] Siru Ouyang, Zhuosheng Zhang, and Hai Zhao. 2021. Fact-driven Logical Reasoning arXiv preprint arXiv:2105.10334.

[8] Ruize Wang, Duyu Tang, Nan Duan, Zhongyu Wei, Xuanjing Huang, Jianshu ji, Guihong Cao, Daxin Jiang, Ming Zhou. 2021. K-adapter: Infusing knowledge into pre-trained models with adapters. In Findings of the Association for Computational Linguistics: ACL-IJCNLP 2021, pages 1405-1418.

[9] Junru Zhou, Zhuosheng Zhang, Hai Zhao, Shuailiang Zhang.2020. LIMIT-BERT: Linguistics Informed Multi-Task BERT. In Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: Findings, pp. 4450-4461.

[10] Zhenzhong Lan, Mingda Chen, Sebastian Goodman, Kevin Gimpel, Piyush Sharma, Radu Soricut. 2020. ALBERT: A Lite BERT for Self-supervised Learning of Language Representations. In International Conference on Learning Representations.